Checkpoints

Create a Cloud Storage bucket

/ 25

Create Cloud Composer environment

/ 25

Uploading the DAG to Cloud Storage

/ 25

Exploring DAG runs

/ 25

Cloud Composer: Qwik Start - Console

- GSP261

- Visão geral

- Objetivos

- Configuração e requisitos

- Tarefa 1: criar o ambiente do Cloud Composer

- Tarefa 2: definição e conceitos principais do Airflow

- Tarefa 3: definir o fluxo de trabalho

- Tarefa 4: consultar as informações do ambiente

- Tarefa 5: usar a interface do Airflow

- Tarefa 6: definir variáveis do Airflow

- Tarefa 7: fazer upload do DAG para o Cloud Storage

- Teste seus conhecimentos

- Excluir ambiente do Cloud Composer

- Parabéns!

- Próximas etapas

GSP261

Visão geral

Os fluxos de trabalho são um tema comum quando falamos em análise de dados. Eles envolvem ingestão, transformação e análise de dados para descobrir informações relevantes. A ferramenta do Google Cloud para hospedagem de fluxos de trabalho é o Cloud Composer. Ele é a versão hospedada da famosa ferramenta de fluxo de trabalho de código aberto Apache Airflow.

Neste laboratório, você usará o console do Cloud para configurar um ambiente do Cloud Composer. Depois, você vai usar o Cloud Composer para realizar um fluxo de trabalho simples que verifica a existência de um arquivo de dados, cria um cluster do Cloud Dataproc para executar um job de contagem de palavras e depois exclui esse cluster.

Objetivos

Neste laboratório, você vai aprender a fazer o seguinte:

- Usar o console do Cloud para criar o ambiente do Cloud Composer

- Abrir e executar o gráfico acíclico dirigido (DAG) na interface da Web do Airflow

- Acessar os resultados do job de contagem de palavras no armazenamento

Configuração e requisitos

Antes de clicar no botão Start Lab

Leia estas instruções. Os laboratórios são cronometrados e não podem ser pausados. O timer é iniciado quando você clica em Começar o laboratório e mostra por quanto tempo os recursos do Google Cloud vão ficar disponíveis.

Este laboratório prático permite que você realize as atividades em um ambiente real de nuvem, não em uma simulação ou demonstração. Você vai receber novas credenciais temporárias para fazer login e acessar o Google Cloud durante o laboratório.

Confira os requisitos para concluir o laboratório:

- Acesso a um navegador de Internet padrão (recomendamos o Chrome).

- Tempo para concluir o laboratório---não se esqueça: depois de começar, não será possível pausar o laboratório.

Como iniciar seu laboratório e fazer login no console do Google Cloud

-

Clique no botão Começar o laboratório. Se for preciso pagar, você verá um pop-up para selecionar a forma de pagamento. No painel Detalhes do laboratório à esquerda, você verá o seguinte:

- O botão Abrir Console do Cloud

- Tempo restante

- As credenciais temporárias que você vai usar neste laboratório

- Outras informações se forem necessárias

-

Clique em Abrir Console do Google. O laboratório ativa recursos e depois abre outra guia com a página Fazer login.

Dica: coloque as guias em janelas separadas lado a lado.

Observação: se aparecer a caixa de diálogo Escolher uma conta, clique em Usar outra conta. -

Caso seja preciso, copie o Nome de usuário no painel Detalhes do laboratório e cole esse nome na caixa de diálogo Fazer login. Clique em Avançar.

-

Copie a Senha no painel Detalhes do laboratório e a cole na caixa de diálogo Olá. Clique em Avançar.

Importante: você precisa usar as credenciais do painel à esquerda. Não use suas credenciais do Google Cloud Ensina. Observação: se você usar sua própria conta do Google Cloud neste laboratório, é possível que receba cobranças adicionais. -

Acesse as próximas páginas:

- Aceite os Termos e Condições.

- Não adicione opções de recuperação nem autenticação de dois fatores (porque essa é uma conta temporária).

- Não se inscreva em testes gratuitos.

Depois de alguns instantes, o console do GCP vai ser aberto nesta guia.

Ativar o Cloud Shell

O Cloud Shell é uma máquina virtual com várias ferramentas de desenvolvimento. Ele tem um diretório principal permanente de 5 GB e é executado no Google Cloud. O Cloud Shell oferece acesso de linha de comando aos recursos do Google Cloud.

- Clique em Ativar o Cloud Shell

na parte de cima do console do Google Cloud.

Depois de se conectar, vai notar que sua conta já está autenticada, e que o projeto está configurado com seu PROJECT_ID. A saída contém uma linha que declara o projeto PROJECT_ID para esta sessão:

gcloud é a ferramenta de linha de comando do Google Cloud. Ela vem pré-instalada no Cloud Shell e aceita preenchimento com tabulação.

- (Opcional) É possível listar o nome da conta ativa usando este comando:

-

Clique em Autorizar.

-

A saída será parecida com esta:

Saída:

- (Opcional) É possível listar o ID do projeto usando este comando:

Saída:

Exemplo de saída:

gcloud, acesse o guia com informações gerais sobre a gcloud CLI no Google Cloud.

Tarefa 1: criar o ambiente do Cloud Composer

Nesta seção, você vai criar um ambiente do Cloud Composer.

-

Acesse o Menu de navegação (

) > Composer.

-

Clique em CRIAR AMBIENTE e selecione Composer 1 no menu suspenso.

-

Defina o seguinte para seu ambiente:

-

Nome:

highcpu -

Local:

-

Versão da imagem: selecione a opção mais recente.

-

Zona:

-

Tipo de máquina:

e2-standard-2

-

Deixe as outras configurações como padrão.

- Clique em CRIAR.

O processo de criação do ambiente será concluído quando uma marca de seleção verde for exibida à esquerda do nome dele na página "Ambientes" no console do Cloud.

O processo de configuração do ambiente pode levar de 10 a 15 minutos. Continue o laboratório enquanto o ambiente é gerado.

Crie um bucket do Cloud Storage

Crie um bucket do Cloud Storage no projeto. Ele é usado como saída para o job do Hadoop no Dataproc.

-

Acesse Menu de navegação > Cloud Storage > Buckets e clique em CRIAR.

-

Dê o nome

e crie o bucket na região . Depois, clique em CRIAR.

Não esqueça o nome do bucket do Cloud Storage (o ID do seu projeto). Ele será usado posteriormente neste laboratório como uma variável do Airflow.

Clique em Verificar meu progresso para conferir o objetivo.

Tarefa 2: definição e conceitos principais do Airflow

Enquanto você aguarda a criação do ambiente do Composer, veja alguns termos usados com o Airflow.

O Airflow é uma plataforma para criar, programar e monitorar fluxos de trabalho programaticamente.

Use o Airflow para criar fluxos de trabalho como gráficos acíclicos dirigidos (DAGs, na sigla em inglês) de tarefas. O programador do Airflow executa suas tarefas em uma matriz de workers enquanto segue as dependências especificadas.

Principais conceitos

Um gráfico acíclico dirigido é uma coleção das tarefas que você quer executar, organizadas para refletir as próprias relações e dependências.

É a descrição de uma única tarefa. Em geral, os operadores são atômicos. Por exemplo, o BashOperator é usado para executar o comando "bash".

Uma instância parametrizada de um operador. As tarefas são nós no DAG.

Uma execução específica de uma tarefa, caracterizada como um DAG, uma tarefa e um ponto no tempo. Ela tem sempre um estado, por exemplo: running, success, failed, skipped etc.

Leia a Documentação sobre conceitos (em inglês) para saber mais.

Tarefa 3: definir o fluxo de trabalho

Agora vamos abordar o fluxo de trabalho usado. No Cloud Composer, os fluxos de trabalho são compostos de gráficos acíclicos dirigidos (DAGs). Os DAGs são definidos em arquivos Python padrão, armazenados na pasta DAG_FOLDER do Airflow. O Airflow executará o código em cada arquivo para criar dinamicamente os objetos DAG. É possível ter quantos DAGs quiser e usar cada um deles para descrever algumas tarefas. Em geral, cada DAG deve corresponder a um único fluxo de trabalho lógico.

-

Abra uma nova janela do Cloud Shell clicando no ícone Ativar Cloud Shell no canto superior direito do console do Cloud.

-

No Cloud Shell, use o nano (um editor de código) para criar o arquivo

hadoop_tutorial.py:

- Confira abaixo o código do fluxo de trabalho hadoop_tutorial.py, também conhecido como DAG. Cole o código a seguir no arquivo

hadoop_tutorial.py.

- Salve e saia do nano pressionando CTRL+O, ENTER e CTRL+X nessa ordem.

Para orquestrar as três tarefas do fluxo de trabalho, o DAG importa os operadores abaixo:

-

DataprocClusterCreateOperator: cria um cluster do Cloud Dataproc. -

DataProcHadoopOperator: envia um job de contagem de palavras do Hadoop e grava os resultados em um bucket do Cloud Storage. -

DataprocClusterDeleteOperator: exclui o cluster para evitar cobranças contínuas do Compute Engine.

As tarefas são executadas sequencialmente, como mostra esta seção do arquivo:

O nome do DAG é hadoop_tutorial, e ele é executado uma vez por dia:

Como o código start_date transmitido para default_dag_args está definido como yesterday, o Cloud Composer programa o fluxo de trabalho para iniciar imediatamente após o DAG ser carregado.

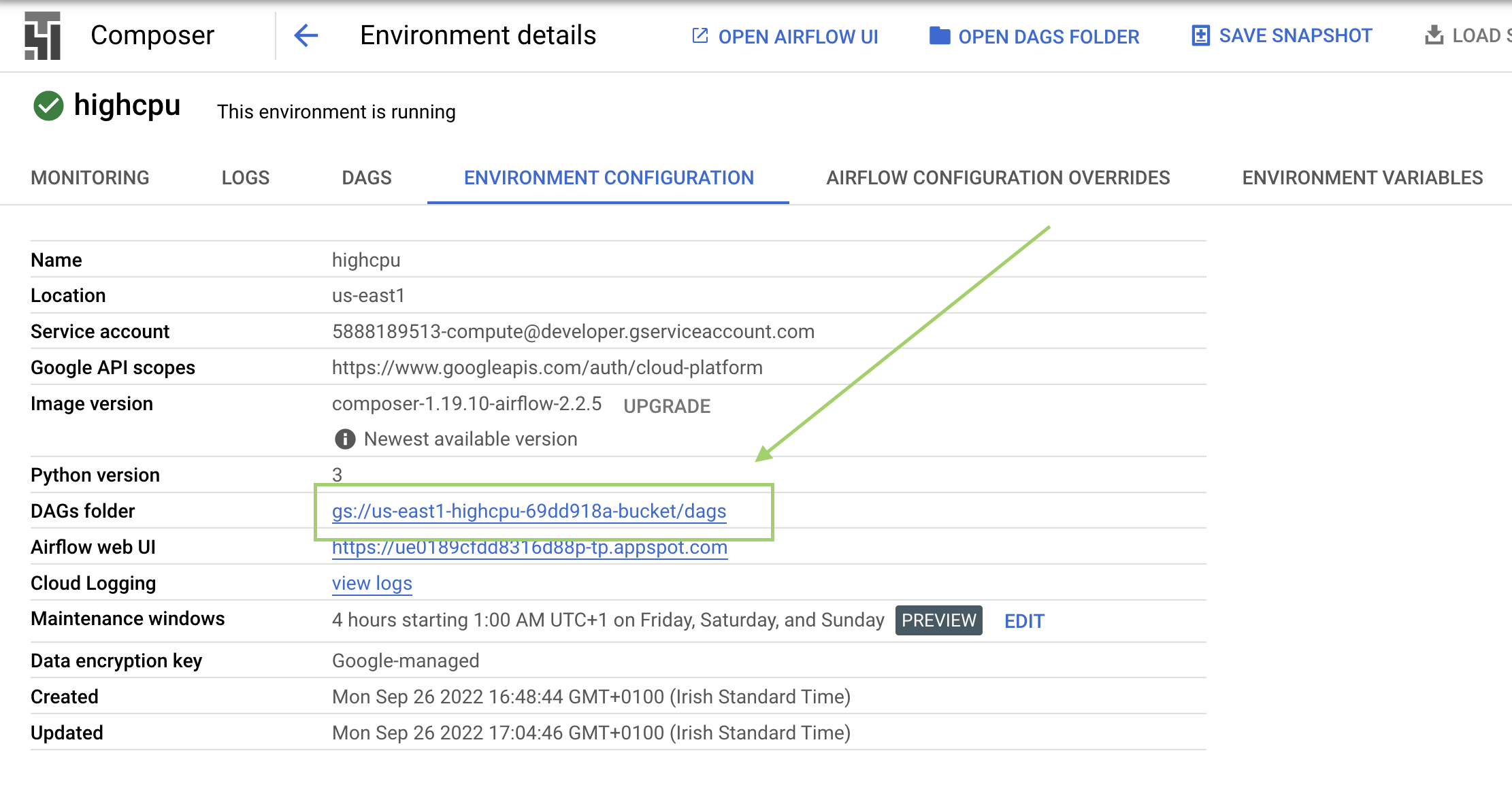

Tarefa 4: consultar as informações do ambiente

-

Volte ao Composer para verificar o status do ambiente.

-

Depois que seu ambiente for criado, clique no nome dele (highcpu) para conferir os detalhes.

Em Detalhes do ambiente, você vê o URL da interface da Web do Airflow, o ID do cluster do Kubernetes Engine e um link para a pasta de DAGs, que está armazenada no seu bucket.

/dags.Clique em Verificar meu progresso para conferir o objetivo.

Tarefa 5: usar a interface do Airflow

Para acessar a interface da Web do Airflow pelo console do Cloud, siga estas etapas:

- Volte para a página Ambientes.

- Na coluna Servidor da Web do Airflow do ambiente, clique em Airflow.

- Clique nas suas credenciais do laboratório.

- A interface da Web do Airflow será aberta em uma nova janela do navegador.

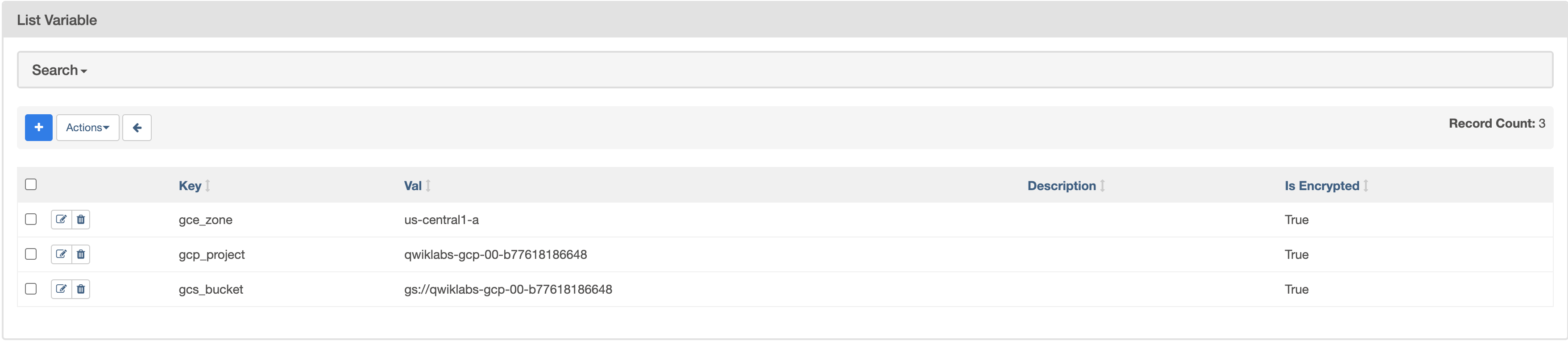

Tarefa 6: definir variáveis do Airflow

As variáveis do Airflow são um conceito específico da plataforma e diferente das variáveis de ambiente.

-

Selecione Admin > Variáveis na barra de menus do Airflow e clique em + (Adicionar um novo registro).

-

Crie as variáveis

gcp_project,gcs_bucketegce_zonedo Airflow:

|

CHAVE |

VALOR |

Detalhes |

|

|

|

O projeto do Google Cloud que você está usando neste guia de início rápido. |

|

|

gs:// |

Este é o nome do bucket do Cloud Storage que você criou anteriormente, que deve ser igual ao ID do projeto, a menos que você o altere. Esse bucket armazena a resposta dos jobs do Hadoop a partir do Dataproc. |

|

|

|

Essa é a zona do Compute Engine em que o cluster do Cloud Dataproc será criado. Para escolher outra opção, consulte Regiões e zonas disponíveis. |

A tabela de variáveis será semelhante a esta no final:

Tarefa 7: fazer upload do DAG para o Cloud Storage

Para fazer upload do DAG, faça o upload de uma cópia do arquivo hadoop_tutorial.py para o bucket do Cloud Storage que foi criado automaticamente quando você criou o ambiente.

-

Para verificar isso, acesse Composer > Ambientes.

-

Clique no ambiente criado anteriormente para conferir os detalhes dele.

-

Clique em Configuração do ambiente.

-

Encontre

DAGs foldere copie o valor que vai substituir<DAGs_folder_path>no comando abaixo e execute-o no Cloud Shell:

O Cloud Composer automaticamente programa e adiciona o DAG ao Airflow. As alterações no DAG levam de três a cinco minutos para serem feitas. O fluxo de trabalho passará a se chamar composer_hadoop_tutorial.

Você poderá ver o status da tarefa na interface da Web do Airflow.

Clique em Verificar meu progresso para conferir o objetivo.

Como o DAG é executado

Quando estiver na pasta dags no Cloud Storage, o arquivo DAG será analisado pelo Cloud Composer. Se nenhum erro for encontrado, o nome do fluxo de trabalho será exibido na lista de DAGs e entrará na fila para ser executado imediatamente.

Verifique se você está na guia DAGs na interface da Web do Airflow. É preciso esperar alguns minutos até que esse processo seja concluído. Atualize o navegador para acessar as informações mais recentes.

-

No Airflow, clique em composer_hadoop_tutorial para abrir a página de detalhes do DAG. Ela inclui uma representação gráfica das tarefas e dependências do fluxo de trabalho.

-

Para acessar este tipo de exibição, clique em Graph na barra de ferramentas. Passe o cursor sobre a representação gráfica de cada tarefa para conferir o status correspondente. A borda das tarefas também indica o status: verde = em execução, vermelha = falha etc.

-

Se necessário, ative a opção Auto refresh ou clique no ícone Refresh para mostrar as informações mais recentes. A borda dos processos muda de cor para indicar o estado.

Se a cor ao redor de create_dataproc_cluster mudar e o estado não for "running", execute o fluxo de trabalho de novo na visualização Graph. Se o estado for "running", não será necessário aplicar as 3 etapas abaixo.

- Clique no gráfico create_dataproc_cluster.

- Clique em Clear para redefinir as três tarefas.

- Depois clique em OK para confirmar.

A cor ao redor de create_dataproc_cluster mudará para refletir o estado "running".

Você também pode monitorar o processo no console do Cloud.

- Assim que o status de create_dataproc_cluster mudar para "running", acesse o Menu de navegação > Dataproc e clique em:

- Clusters para monitorar a criação e a exclusão de clusters. O cluster criado pelo fluxo de trabalho é efêmero e será excluído como parte da última tarefa após a execução do fluxo;

- Jobs para monitorar o job de contagem de palavras do Apache Hadoop. Clique no ID do job para ver a saída do registro dele.

-

Quando o Dataproc alcançar o estado "running", volte para o Airflow e clique em Refresh para conferir se o cluster está completo.

-

Ao final do processo

run_dataproc_hadoop, acesse o Menu de navegação > Cloud Storage > Buckets e clique no nome do seu bucket para conferir os resultados da contagem de palavras na pastawordcount.

Selecione Verificar meu progresso para conferir o objetivo.

Teste seus conhecimentos

Faça nosso teste para avaliar o quanto você sabe sobre o Google Cloud Platform.

Excluir ambiente do Cloud Composer

- Retorne à página Ambientes no Composer.

- Marque a caixa de seleção ao lado do ambiente do Composer.

- Clique em EXCLUIR.

- Confirme o pop-up clicando em EXCLUIR novamente.

Parabéns!

Parabéns! Neste laboratório, você criou um ambiente do Cloud Composer, fez upload de um DAG para o Cloud Storage e executou um fluxo de trabalho que criou um cluster do Cloud Dataproc, executou um job de contagem de palavras do Hadoop e excluiu o cluster. Você também aprendeu sobre o Airflow e os conceitos básicos, além de analisar a interface da web do Airflow. Agora você pode usar o Cloud Composer para criar e gerenciar seus fluxos de trabalho.

Próximas etapas

Este laboratório faz parte de uma série chamada Qwik Starts. Ela foi desenvolvida para apresentar a você alguns dos recursos disponíveis no Google Cloud. Pesquise "Qwik Starts" no catálogo de laboratórios para encontrar algum que seja do seu interesse.

- Para conferir o valor de uma variável, execute o subcomando variables da CLI do Airflow com o argumento "get" ou use a interface da Web do Airflow.

- Para mais informações sobre a interface da Web do Airflow, consulte Como acessar a interface da Web.

Treinamento e certificação do Google Cloud

Esses treinamentos ajudam você a aproveitar as tecnologias do Google Cloud ao máximo. Nossas aulas incluem habilidades técnicas e práticas recomendadas para ajudar você a alcançar rapidamente o nível esperado e continuar sua jornada de aprendizado. Oferecemos treinamentos que vão do nível básico ao avançado, com opções de aulas virtuais, sob demanda e por meio de transmissões ao vivo para que você possa encaixá-las na correria do seu dia a dia. As certificações validam sua experiência e comprovam suas habilidades com as tecnologias do Google Cloud.

Manual atualizado em 18 de dezembro de 2023

Laboratório testado em 18 de dezembro de 2023

Copyright 2024 Google LLC. Todos os direitos reservados. Google e o logotipo do Google são marcas registradas da Google LLC. Todos os outros nomes de produtos e empresas podem ser marcas registradas das respectivas empresas a que estão associados.