Checkpoints

Create a Dataset

/ 20

Create a sink

/ 20

Run example queries

/ 30

Viewing the logs in BigQuery

/ 30

Como usar o BigQuery e o Cloud Logging para analisar o uso do BigQuery

GSP617

Visão geral

O Cloud Logging atua como repositório central para registros de vários serviços do Google Cloud, como o BigQuery, e é ideal para armazenamento de registros de curto e médio prazo. Muitos setores exigem que os registros sejam retidos por longos períodos. Se você quiser manter registros e realizar análises históricas estendidas ou auditorias complexas, configure um coletor que exporte registros específicos para o BigQuery.

Neste laboratório, você vai conferir os registros do BigQuery que estão no Cloud Logging, configurar um coletor a fim de exportá-los para o BigQuery e usar SQL para analisá-los.

Configuração e requisitos

Antes de clicar no botão Start Lab

Leia estas instruções. Os laboratórios são cronometrados e não podem ser pausados. O timer é iniciado quando você clica em Começar o laboratório e mostra por quanto tempo os recursos do Google Cloud vão ficar disponíveis.

Este laboratório prático permite que você realize as atividades em um ambiente real de nuvem, não em uma simulação ou demonstração. Você vai receber novas credenciais temporárias para fazer login e acessar o Google Cloud durante o laboratório.

Confira os requisitos para concluir o laboratório:

- Acesso a um navegador de Internet padrão (recomendamos o Chrome).

- Tempo para concluir o laboratório---não se esqueça: depois de começar, não será possível pausar o laboratório.

Como iniciar seu laboratório e fazer login no console do Google Cloud

-

Clique no botão Começar o laboratório. Se for preciso pagar, você verá um pop-up para selecionar a forma de pagamento. No painel Detalhes do laboratório à esquerda, você verá o seguinte:

- O botão Abrir Console do Cloud

- Tempo restante

- As credenciais temporárias que você vai usar neste laboratório

- Outras informações se forem necessárias

-

Clique em Abrir Console do Google. O laboratório ativa recursos e depois abre outra guia com a página Fazer login.

Dica: coloque as guias em janelas separadas lado a lado.

Observação: se aparecer a caixa de diálogo Escolher uma conta, clique em Usar outra conta. -

Caso seja preciso, copie o Nome de usuário no painel Detalhes do laboratório e cole esse nome na caixa de diálogo Fazer login. Clique em Avançar.

-

Copie a Senha no painel Detalhes do laboratório e a cole na caixa de diálogo Olá. Clique em Avançar.

Importante: você precisa usar as credenciais do painel à esquerda. Não use suas credenciais do Google Cloud Ensina. Observação: se você usar sua própria conta do Google Cloud neste laboratório, é possível que receba cobranças adicionais. -

Acesse as próximas páginas:

- Aceite os Termos e Condições.

- Não adicione opções de recuperação nem autenticação de dois fatores (porque essa é uma conta temporária).

- Não se inscreva em testes gratuitos.

Depois de alguns instantes, o console do GCP vai ser aberto nesta guia.

Ativar o Cloud Shell

O Cloud Shell é uma máquina virtual com várias ferramentas de desenvolvimento. Ele tem um diretório principal permanente de 5 GB e é executado no Google Cloud. O Cloud Shell oferece acesso de linha de comando aos recursos do Google Cloud.

- Clique em Ativar o Cloud Shell

na parte de cima do console do Google Cloud.

Depois de se conectar, vai notar que sua conta já está autenticada, e que o projeto está configurado com seu PROJECT_ID. A saída contém uma linha que declara o projeto PROJECT_ID para esta sessão:

gcloud é a ferramenta de linha de comando do Google Cloud. Ela vem pré-instalada no Cloud Shell e aceita preenchimento com tabulação.

- (Opcional) É possível listar o nome da conta ativa usando este comando:

-

Clique em Autorizar.

-

A saída será parecida com esta:

Saída:

- (Opcional) É possível listar o ID do projeto usando este comando:

Saída:

Exemplo de saída:

gcloud, acesse o guia com informações gerais sobre a gcloud CLI no Google Cloud.

Tarefa 1: abrir o BigQuery

Abrir o console do BigQuery

- No Console do Google Cloud, selecione o menu de navegação > BigQuery:

Você verá a caixa de mensagem Olá! Este é o BigQuery no Console do Cloud. Ela tem um link para o guia de início rápido e as notas de versão.

- Clique em OK.

O console do BigQuery vai abrir.

Tarefa 2: criar um conjunto de dados

-

Na seção Explorador, clique nos três pontos ao lado do projeto que começa com

qwiklabs-gcp-. -

Clique em Criar conjunto de dados.

-

Defina o ID do conjunto de dados como bq_logs.

-

Clique em CRIAR CONJUNTO DE DADOS.

Clique em Verificar meu progresso para conferir o objetivo.

Tarefa 3: executar uma consulta

Primeiro execute uma consulta simples que gere um registro. Você vai usar esse registro mais tarde a fim de configurar a exportação de registros para o BigQuery.

- Copie e cole a consulta abaixo no Editor de consultas do BigQuery:

- Clique em EXECUTAR.

Tarefa 4: configurar a exportação de registros do Cloud Logging

- No console do Cloud, selecione Menu de navegação > Logging > Análise de registros.

-

Em Recurso, selecione BigQuery e clique em Aplicar.

-

Depois clique no botão Executar consulta no canto superior direito.

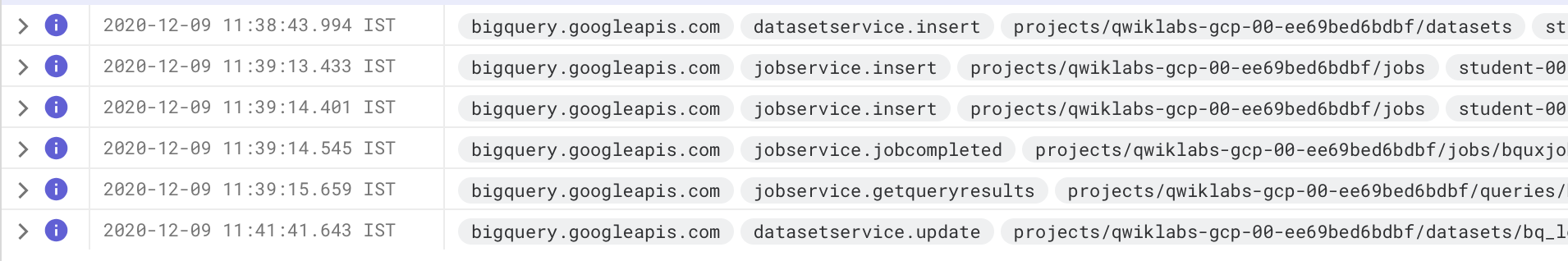

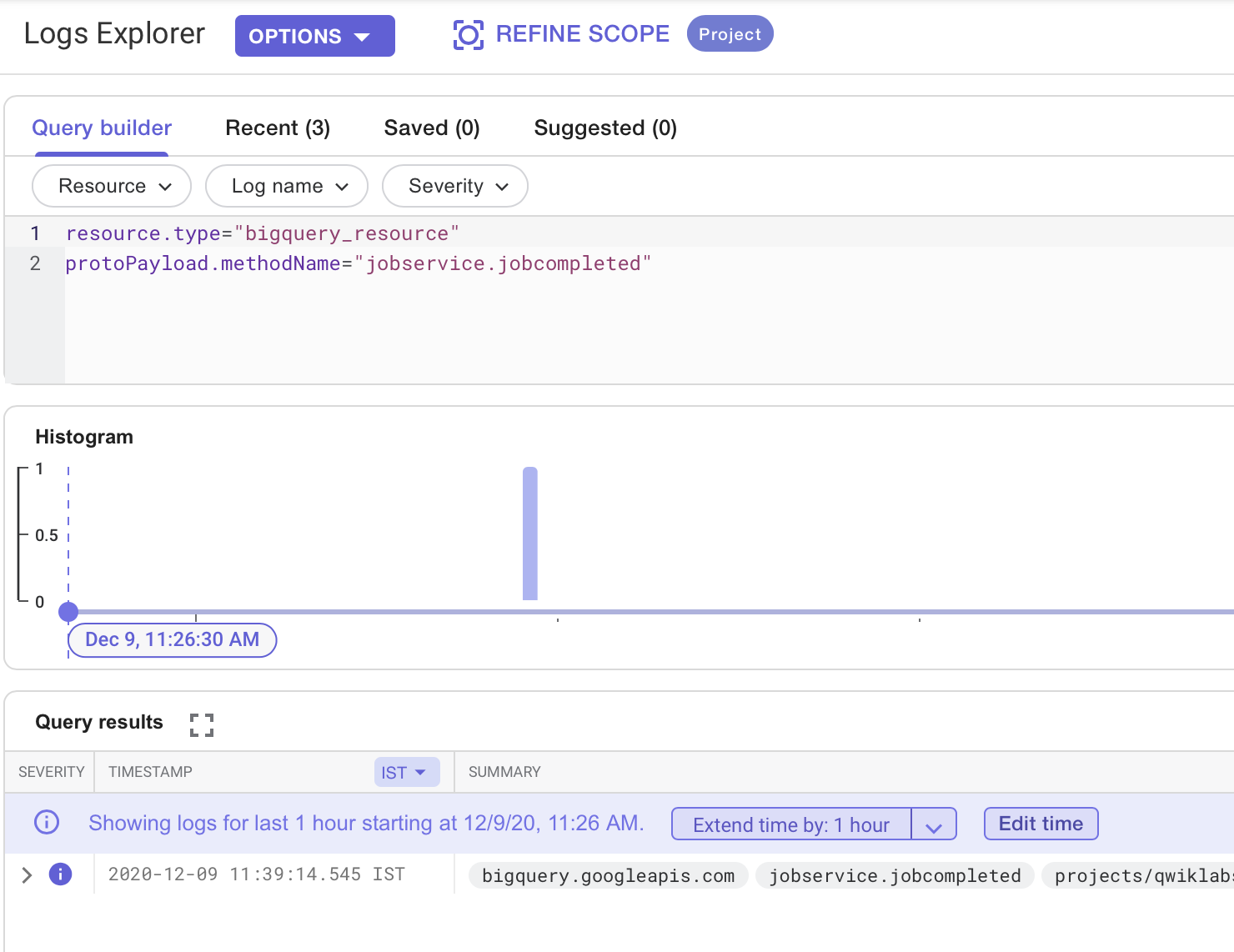

Devem ser exibidas algumas entradas de registro da consulta.

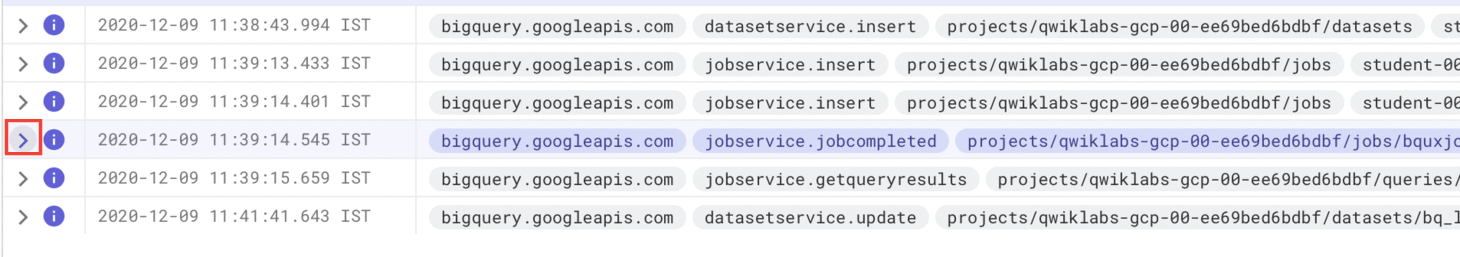

Procure aquela que contém a palavra "jobcompleted".

- Clique na seta à esquerda para expandir a entrada.

Depois clique no botão Expandir campos aninhados no lado direito.

A entrada de registro JSON completa será exibida. Role para baixo e confira os diferentes campos.

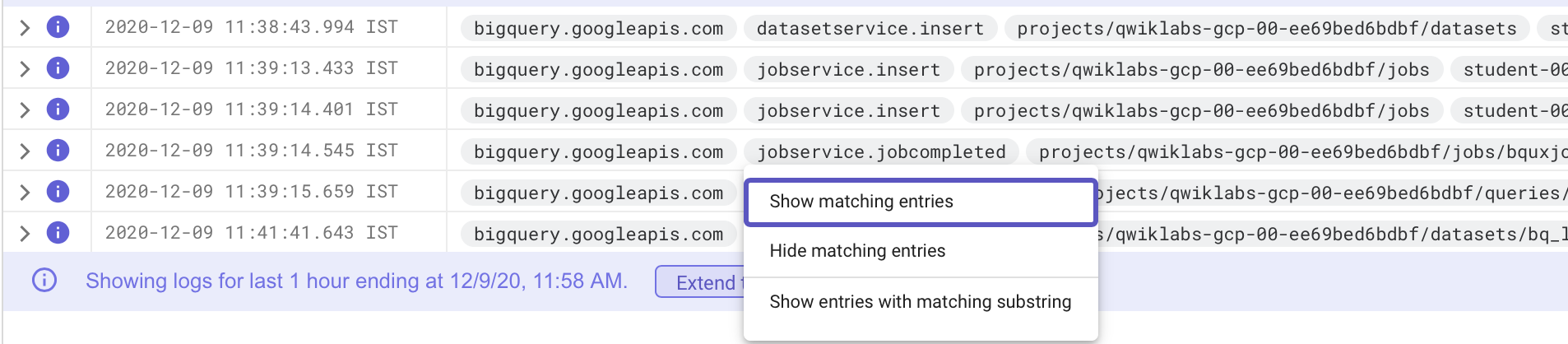

- Depois, role de volta até o cabeçalho da entrada, clique em jobcompleted e selecione Mostrar entradas correspondentes.

Isso configura a pesquisa com os termos corretos. Talvez seja necessário ativar o botão Mostrar consulta para vê-la.

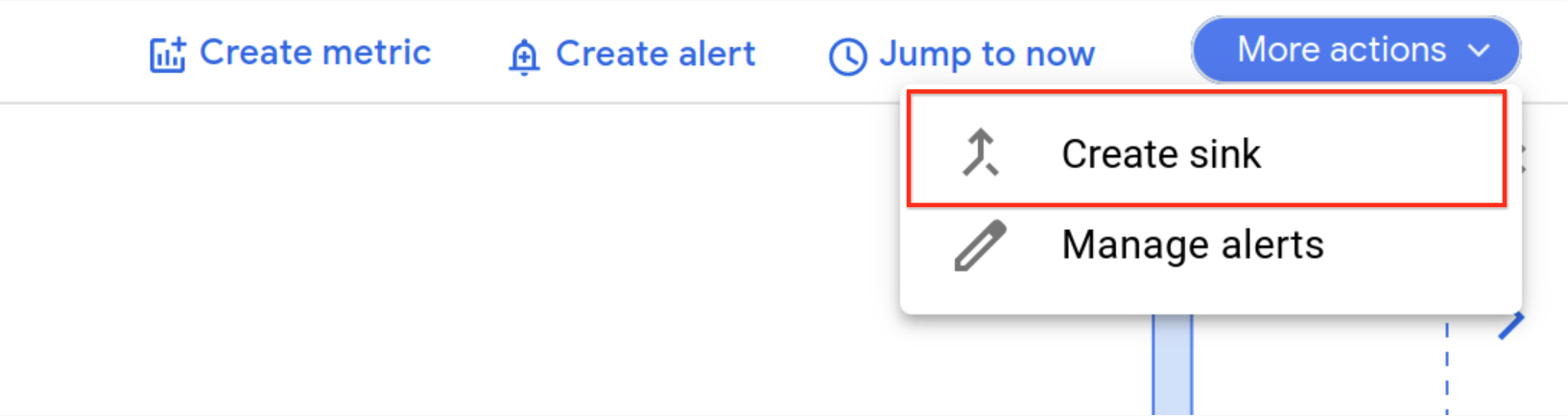

Criar coletor

Agora que você tem os registros necessários, é hora de configurar um coletor.

- Clique em Criar coletor no menu suspenso Mais ações.

- Preencha os campos da seguinte forma:

- Nome do coletor: JobComplete e clique em PRÓXIMA.

- Selecione o serviço do coletor: conjunto de dados do BigQuery

- Selecione o conjunto de dados do BigQuery (destino): bq_logs (o conjunto de dados que você já configurou)

- Mantenha o restante das opções nas configurações padrão.

- Clique em CRIAR COLETOR.

Todas as próximas entradas de registro do BigQuery serão exportadas para uma tabela no conjunto de dados bq_logs.

Clique em Verificar meu progresso para conferir o objetivo.

Tarefa 5: executar consultas de exemplo

Para preencher a nova tabela com alguns registros, execute algumas consultas de exemplo.

- Acesse o Cloud Shell e adicione cada um dos seguintes comandos do BigQuery:

Você vai receber os resultados de cada consulta retornada.

Clique em Verificar meu progresso para conferir o objetivo.

Tarefa 6: exibir os registros no BigQuery

-

Volte ao BigQuery (Menu de navegação > BigQuery).

-

Expanda o recurso que começa com o nome qwiklabs-gcp- e expanda o conjunto de dados bq_logs.

O nome pode variar, mas deve ser exibida uma tabela "cloudaudit_googleapis_com_data_access".

- Clique no nome da tabela. Ao inspecionar o esquema dela, é possível notar que ela conta com um grande número de campos.

Ao clicar em Prévia, é possível que os registros das últimas consultas executadas não sejam exibidos. Como esses registros são transmitidos para a tabela, é possível consultar os novos dados, mas eles ainda vão demorar algum tempo para aparecer na Prévia.

Se você quiser tornar a tabela mais utilizável, crie uma VISUALIZAÇÃO, que extrai um subconjunto de campos e realiza alguns cálculos a fim de derivar uma métrica para o tempo de consulta.

- Clique em Escrever nova consulta. No editor de consultas do BigQuery, execute o seguinte SQL depois de substituir pelo nome do seu projeto (para copiar o ID do projeto com facilidade, acesse o painel Detalhes do laboratório no lado esquerdo da página do laboratório):

Clique em Verificar meu progresso para conferir o objetivo.

- Agora é hora de consultar a VISUALIZAÇÃO. Crie uma nova consulta e execute o seguinte comando:

- Percorra os resultados das consultas executadas.

Parabéns!

Você exportou os registros do BigQuery que estão no Cloud Logging para uma tabela do BigQuery e os analisou com SQL.

Próximas etapas/Saiba mais

- Confira a documentação do Cloud Logging.

- Confira a documentação do BigQuery.

Treinamento e certificação do Google Cloud

Esses treinamentos ajudam você a aproveitar as tecnologias do Google Cloud ao máximo. Nossas aulas incluem habilidades técnicas e práticas recomendadas para ajudar você a alcançar rapidamente o nível esperado e continuar sua jornada de aprendizado. Oferecemos treinamentos que vão do nível básico ao avançado, com opções de aulas virtuais, sob demanda e por meio de transmissões ao vivo para que você possa encaixá-las na correria do seu dia a dia. As certificações validam sua experiência e comprovam suas habilidades com as tecnologias do Google Cloud.

Manual atualizado em 5 de fevereiro de 2024

Laboratório testado em 27 de setembro de 2023

Copyright 2024 Google LLC. Todos os direitos reservados. Google e o logotipo do Google são marcas registradas da Google LLC. Todos os outros nomes de produtos e empresas podem ser marcas registradas das respectivas empresas a que estão associados.